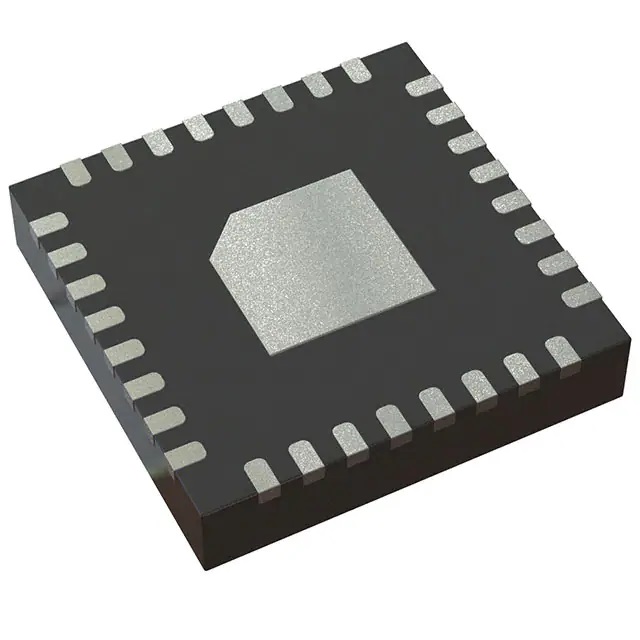

XC7Z020-2CLG484I Nei Original Elektronesch Komponenten Integréiert Circuits BGA484 IC SOC CORTEX-A9 766MHZ 484BGA

Produit Attributer

| TYPE | BESCHREIWUNG |

| Kategorie | Integréiert Circuits (ICs) |

| Mfr | AMD Xilinx |

| Serie | Zynq®-7000 |

| Package | Schacht |

| Standard Package | 84 |

| Produit Status | Aktiv |

| Architektur | MCU, FPGA |

| Kär Prozessor | Dual ARM® Cortex®-A9 MPCore™ mat CoreSight™ |

| Flash Gréisst | - |

| RAM Gréisst | 256KB |

| Peripheriegeräter | DMA |

| Konnektivitéit | CANbus, EBI/EMI, Ethernet, I²C, MMC/SD/SDIO, SPI, UART/USART, USB OTG |

| Speed | 766MHz |

| Primär Attributer | Artix™-7 FPGA, 85K Logik Zellen |

| Operatioun Temperatur | -40°C ~ 100°C (TJ) |

| Package / Fall | 484-LFBGA, CSPBGA |

| Fournisseur Apparat Package | 484-CSPBGA (19×19) |

| Zuel vun ech / O | 130 |

| Basis Produit Zuel | XC7Z020 |

Kommunikatioun ass dee meescht benotzte Szenario fir FPGAs

Am Verglach mat aner Aarte vu Chips ass d'Programméierbarkeet (Flexibilitéit) vun FPGAs héich gëeegent fir déi kontinuéierlech iterativ Upgrade vu Kommunikatiounsprotokoller.Dofir gi FPGA Chips vill a drahtlose a kabellos Kommunikatiounsapparater benotzt.

Mat dem Advent vun der 5G Ära klammen FPGAs am Volume a Präis.Wat d'Quantitéit ugeet, wéinst der méi héijer Frequenz vum 5G Radio, fir datselwecht Ofdeckungsziel wéi 4G z'erreechen, sinn ongeféier 3-4 Mol d'Zuel vun de 4G Basisstatiounen erfuerderlech (a China, zum Beispill, bis Enn 20. Gesamtzuel vun de mobilen Kommunikatiounsbasisstatiounen a China erreecht 9.31 Milliounen, mat enger Nettoerhéijung vun 900.000 fir d'Joer, vun deenen d'Gesamtzuel vun 4G Basisstatiounen 5.75 Milliounen erreecht huet), an déi zukünfteg Maartbauskala gëtt erwaart an den Zénger ze sinn. vu Millioune.Zur selwechter Zäit, wéinst der héijer concurrent Veraarbechtungsfuerderung vun der ganzer Kolonn vu grousser Skala Antennen, gëtt d'FPGA Notzung vun 5G Single Base Statiounen vun 2-3 Blocken op 4-5 Blocks vergréissert am Verglach zu 4G Single Base Statiounen.Als Resultat wäert d'FPGA Notzung, e Kärkomponent vun der 5G Infrastruktur an der Terminalausrüstung, och eropgoen.Wat Eenheetspräis ugeet, ginn FPGAs haaptsächlech am Baseband vun Transceiver benotzt.D'5G Ära wäert eng Erhéijung vun der Skala vun de benotzte FPGAs gesinn wéinst der Erhéijung vun der Unzuel vun de Kanäl an der Erhéijung vun der computationaler Komplexitéit, a well d'Präisser vun FPGAs positiv mat On-Chip Ressourcen korreléiert sinn, gëtt den Eenheetspräis erwaart an Zukunft weider eropgoen.FY22Q2, Xilinx 'Wireline, a Wireless Einnahmen sinn ëm 45,6% Joer-op-Joer eropgaang op US $ 290 Milliounen, wat 31% vum Gesamtakommes ausmaachen.

FPGAs kënnen als Datenzenter Beschleuniger, AI Beschleuniger, SmartNICs (intelligent Netzwierkkaarten) a Beschleuniger an der Netzwierkinfrastruktur benotzt ginn.An de leschte Joeren huet de Boom an der kënschtlecher Intelligenz, Cloud Computing, High-Performance Computing (HPC), an autonom Fuere FPGAs neie Maartimpuls ginn an inkrementelle Raum katalyséiert.

Nofro fir FPGAs gedriwwe vun AI Beschleuniger Kaarten

Wéinst hirer Flexibilitéit an High-Speed-Computerfäegkeeten gi FPGAs vill an AI Beschleunigerkaarte benotzt.Am Verglach mat GPUs hunn FPGAs offensichtlech Energieeffizienz Virdeeler;am Verglach mat ASICs hunn FPGAs méi Flexibilitéit fir déi méi séier Evolutioun vun AI neural Netzwierker ze passen an mat den iterativen Updates vun Algorithmen ze halen.Profitéiert vun der breeder Entwécklungsperspektive vu kënschtlecher Intelligenz, wäert d'Demande fir FPGAs fir AI Uwendungen an Zukunft weider verbesseren.Laut SemicoResearch wäert d'Maartgréisst vun FPGAs an AI Applikatiounsszenarien dräifach an 19-23 fir US $ 5.2 Milliarde z'erreechen.Am Verglach zum $8.3 Milliarde FPGA Maart am '21, kann d'Potenzial fir Uwendungen an AI net ënnerschat ginn.

E méi villverspriechend Maart fir FPGAs ass den Rechenzentrum

Datenzentere sinn ee vun den opkomende Applikatiounsmäert fir FPGA Chips, mat gerénger latency + héijen Duerchsatz, déi d'Kärstäerkten vun FPGAs leeën.Datacenter FPGAs ginn haaptsächlech fir Hardware Beschleunigung benotzt a kënne bedeitend Beschleunegung erreechen wann Dir personaliséiert Algorithmen am Verglach mat traditionelle CPU-Léisungen veraarbecht: zum Beispill huet de Microsoft Catapult-Projet FPGAs benotzt anstatt CPU-Léisungen am Rechenzentrum fir dem Bing seng personaliséiert Algorithmen 40 Mol méi séier ze veraarbechten, mat bedeitende Beschleunigungseffekter.Als Resultat sinn FPGA Beschleuniger op Serveren a Microsoft Azure, Amazon AWS, an AliCloud agesat ginn fir Rechenbeschleunigung zënter 2016. Am Kontext vun der Epidemie, déi d'global digital Transformatioun beschleunegt, wäerten déi zukünfteg Datenzenter Ufuerderunge fir Chipleistung weider eropgoen, a méi Daten Zentren wäert FPGA Chip Léisungen adoptéieren, déi wäert och de Wäert Undeel vun FPGA Chips an Daten Zentrum Chips Erhéijung.